公众号关注 “GitHub AI 开源”

这期给大家介绍一款开源网络爬虫,可以爬取社交媒体上的图片、视频、评论,适用于微博,小红书,抖音,B 站等 。

项目简介

MediaCrawler 是一个开源免费的自媒体爬虫解决方案,使用 Python 语言编写,支持多个自媒体平台,包括某书、某音、某博、B 站、某手。

做到了开箱即用,使用 Python 原生协程模式进行开发,方便实现二次开发以及实现高并发爬虫的模型,亦可使用同样的解决方案去规避一些逆向难度高的网站。

项目特点

-

开箱即用

-

适用于主流的媒体网站,比如小红书,抖音等 -

支持多种数据保存方式,如 mysql , csv,json等

安装

# 进入项目根目录cd MediaCrawler# 创建虚拟环境# 注意 python 版本需要 3.7 - 3.9python -m venv venv# macos & linux 激活虚拟环境source venv/bin/activate# windows 激活虚拟环境venvScriptsactivate

pip3 install -r requirements.txt4.安装 playwright 浏览器驱动

playwright install运行爬虫程序

执行下面的命令,就可以运行爬虫,抓取指定网站的信息:

# 从配置文件中读取关键词搜索相关的帖子并爬取帖子信息与评论python main.py --platform xhs --lt qrcode --type search# 从配置文件中读取指定的帖子 ID 列表获取指定帖子的信息与评论信息python main.py --platform xhs --lt qrcode --type detail# 打开对应 APP 扫二维码登录# 其他平台爬虫使用示例,执行下面的命令查看python main.py --help

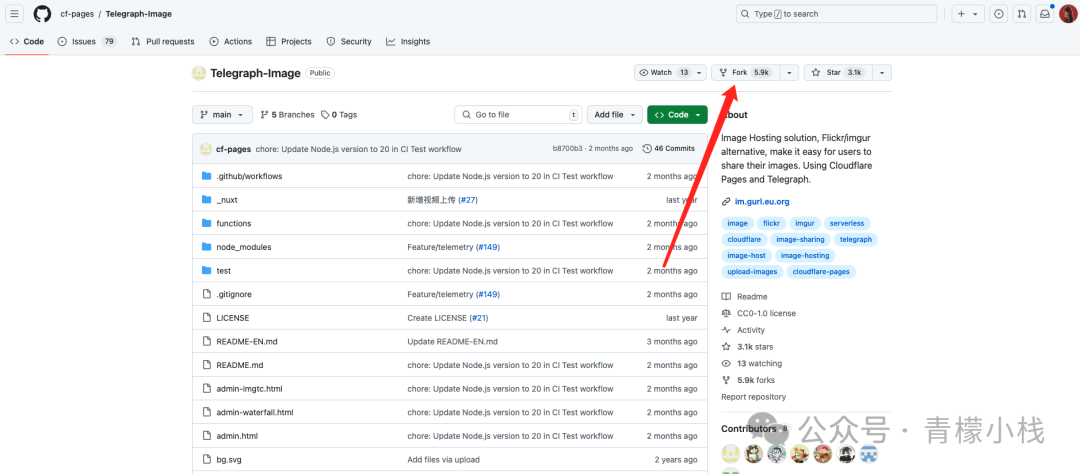

https://github.com/NanmiCoder/MediaCrawler

大模型时代,数据就是 AI 的燃料。我自己也在维护一个 Github爬虫,每天爬一下Github热门仓库,跟踪开源热点。

但是使用爬虫时,我们需要遵守网站的 robots.txt 协议和相关的法律法规,避免触碰数据合规红线,否则真的应了那句话“爬虫玩得好,某饭吃到饱”。

这里顺便推荐一个整理了所有中国大陆爬虫开发者涉诉与违规相关的新闻、资料与法律法规的开源仓库,供大家参考学习:

https://github.com/HiddenStrawberry/Crawler_Illegal_Cases_In_China

![【学习强国】[挑战答题]带选项完整题库(2020年4月20日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/timg-300x200.jpg)

![【学习强国】[新闻采编学习(记者证)]带选项完整题库(2019年11月1日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/77ed36f4b18679ce54d4cebda306117e-300x200.jpg)