地址: https://github.com/shibing624/MedicalGPT

fork: 38 star: 330 开发语言: Python

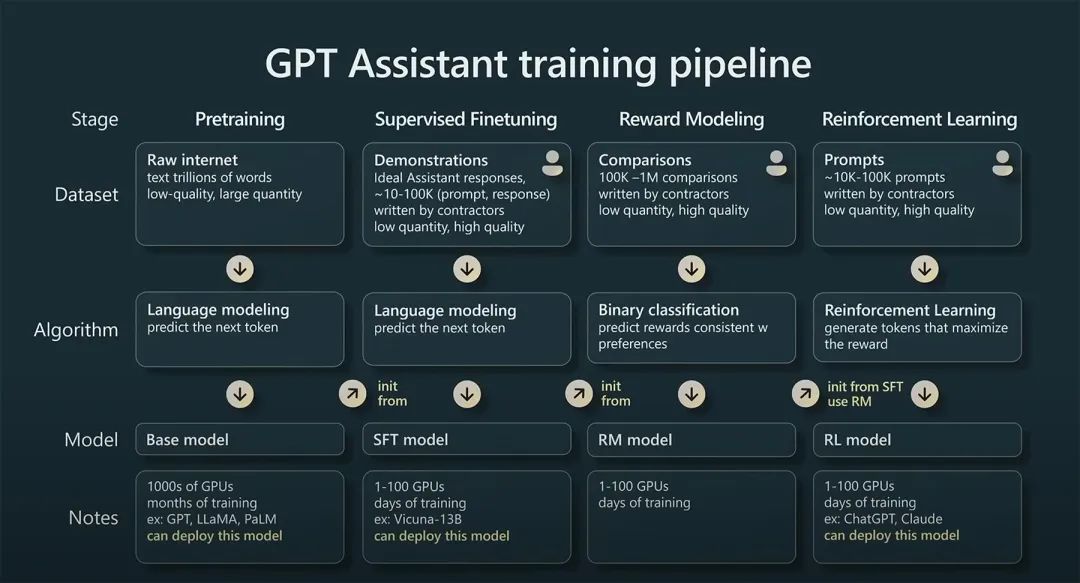

项目简介: MedicalGPT: Training Your Own Medical GPT Model with ChatGPT Training Pipeline. 训练医疗大模型,实现包括二次预训练、有监督微调、奖励建模、强化学习训练。

四个训练阶段分别为

在实际训练中,可以分别执行每个阶段,同时也可以项目提供的脚本,将四个阶段串起来训练的 pipeline,四阶段 pipling 运行耗时大约在 15 分钟。

python gradio_demo.py --model_type base_model_type --base_model path_to_llama_hf_dir --lora_model path_to_lora_dir

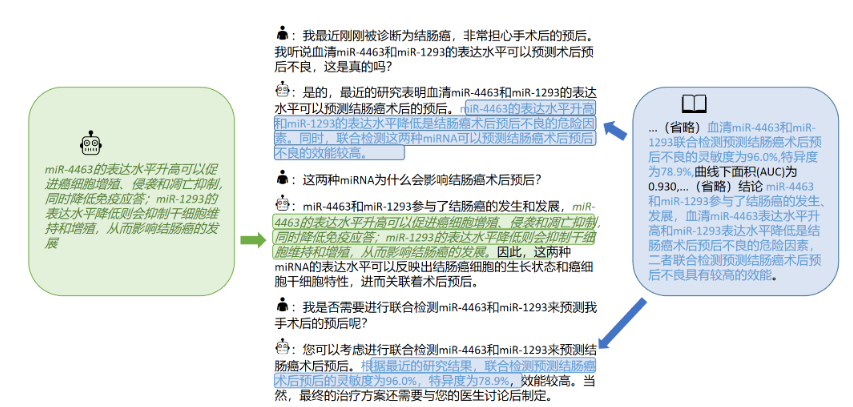

web 界面启动后,便可以输入问题,开始问答了。

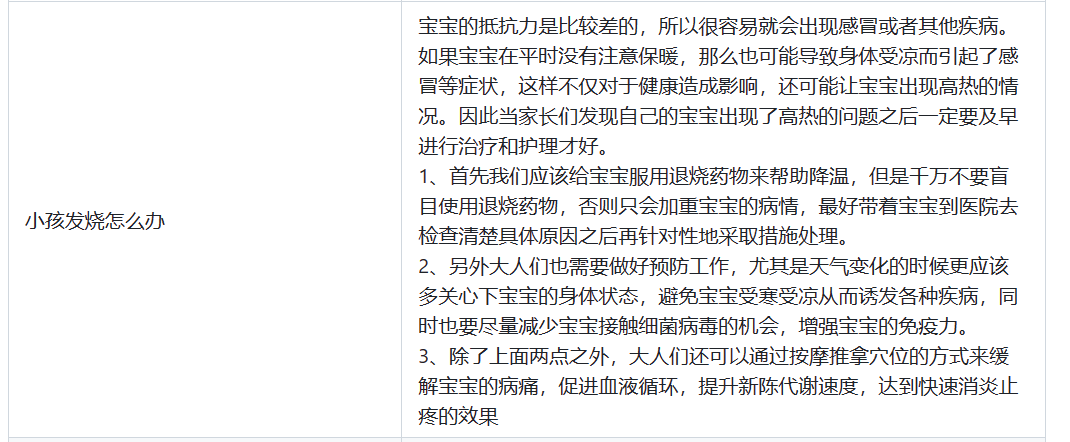

比如可以输入“小孩发烧怎么办”

又或者咨询痤疮或者青春痘等

MedicalGPT 的出现再一次证明了 GPT 在医学领域也能发挥很大的作用,相信在不远的将来,真正的 AI 医生就能开始会我们服务了。

更多的内容,比如微调后的 LoRA 权重 等,请到 Github 上面观看:

END

© 版权声明

博主的文章没有高度、深度和广度,只是凑字数。利用读书、参考、引用、抄袭、复制和粘贴等多种方式打造成自己的纯镀 24k 文章!如若有侵权,请联系博主删除。

喜欢就点个赞吧

![【学习强国】[挑战答题]带选项完整题库(2020年4月20日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/timg-300x200.jpg)

![【学习强国】[新闻采编学习(记者证)]带选项完整题库(2019年11月1日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/77ed36f4b18679ce54d4cebda306117e-300x200.jpg)