公众号关注 “GitHub AI 开源”

设为 “星标”,每天看看 AI 开源项目!

Animate Anyone 可以根据静态的图片生成角色的视频,短短四个月的时间就收获了 13.8K 的 star。

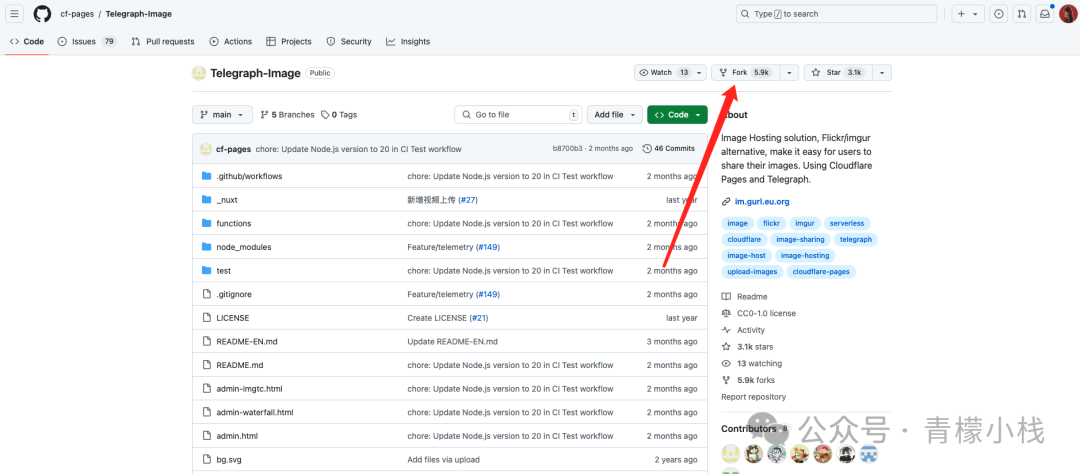

虽然收获了这么多的 star,但是Animate Anyone 并没有公开自己的源码,只是公开了论文和演示的视频 demo。

虽然Animate Anyone 团队在公告中发布表明他们正在积极准备公开发布的演示和代码,但是却无法承诺具体的发布日期。

目前给出的理由是:我们的目标不仅是共享代码,还要确保它是健壮和用户友好的,将其从学术原型过渡到更完善的版本,以提供无缝体验。

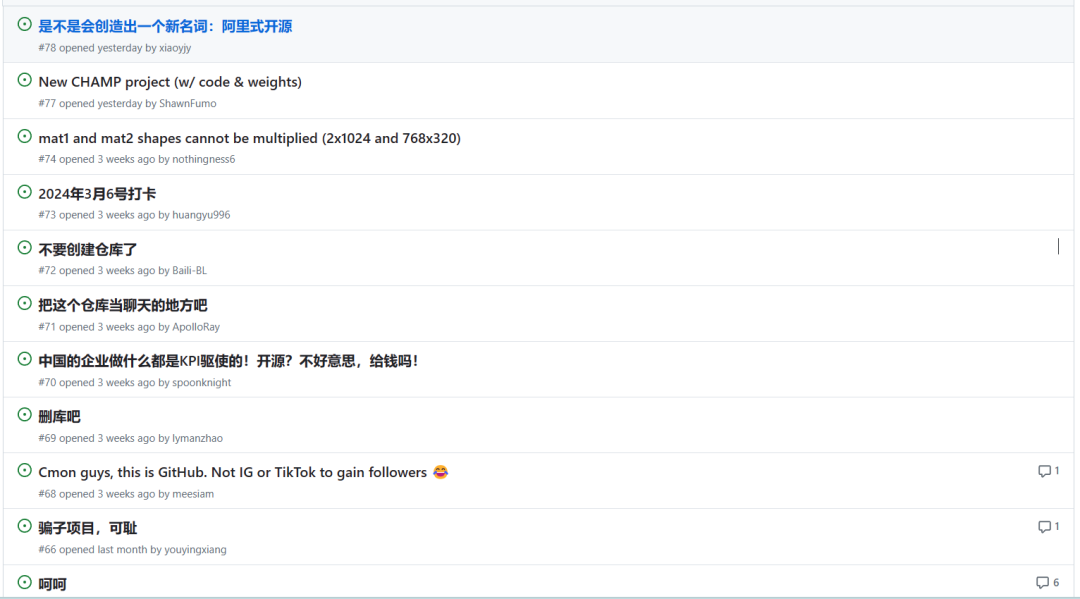

当然,并不是所有的人都相信这份声明,所以在 issues 区就出现了很多有意思的评论,比如“会不会创造出一个新名词:阿里式开源”,“这里是 github,不是 tiktok 或者 IG,来获得粉丝的”,更有直接说“删库”或者说是“骗子项目”的。

还有人直接说,不要相信这份声明,或者说自己已经 60 岁了,应该是等不到Animate Anyone 团队公开源码了。

Animate Anyone 项目虽然还没有公开源码,但是目前已经公开了论文和演示视频demo。

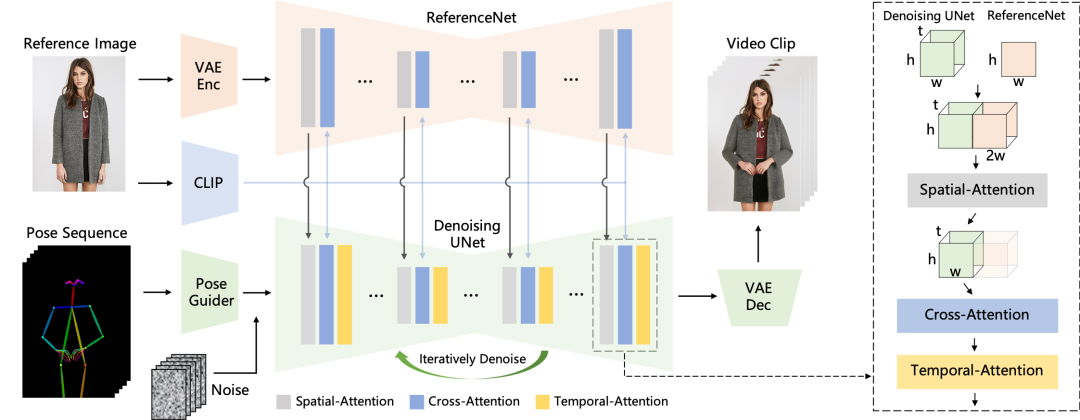

根据团队公开的论文,可以看到他们将图片生成视频的方法如下:

姿态序列最初使用 Pose Guider 进行编码,并与多帧噪声融合,然后由 Denoising UNet 进行去噪过程以生成视频。

去噪 UNet 的计算块由空间注意力、交叉注意力和时间注意力组成,如右侧虚线框所示。

参考图像的集成涉及两个方面。首先,通过 ReferenceNet 提取详细特征并用于空间注意力。其次,通过 CLIP 图像编码器提取语义特征进行交叉注意力;时间注意力在时间维度上运作。最后,VAE 解码器将结果解码为视频剪辑。

视频演示 demo:

Anime/Cartoon 动漫/卡通

Humanoid 人形

为任何人着装:适合任何服装和任何人的超高品质虚拟试穿。

图像到会说话的视频

![【学习强国】[挑战答题]带选项完整题库(2020年4月20日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/timg-300x200.jpg)

![【学习强国】[新闻采编学习(记者证)]带选项完整题库(2019年11月1日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/77ed36f4b18679ce54d4cebda306117e-300x200.jpg)